Sylvestre a écrit : ↑dim. août 28, 2022 11:10 am (Je remarque en passant que les toutes les illustrations sont faites par l’IA Midjourney, ça risque de devenir de plus en plus fréquent à mon avis : plutôt que d’utiliser des images de stock tu écris littéralement l’illustration que tu souhaites et hop tu as une image chelou mais évocatrice -en tous cas ici ça fonctionne bien)

Cryoban a écrit : ↑dim. août 28, 2022 12:12 pm Les illustrations de ce genre sont une révolution pour les petits auteurs qui n'ont pas de trésorerie ou même pour les jdra ou il est impossible d'investir dans des illustrations pro à moins d'être très à l'aise. Entre les IA et les images de stock-art, ca devient possible de sortir quelque chose qui retiendra l'attention d'un lecteur pendant plus de 30s

Saladdin a écrit : ↑dim. août 28, 2022 1:36 pm Les problèmes de droit sont importants, en effet, et les personnes utilisant l'IA n'en sont pas encore conscientes. Aux États-Unis, l'art généré par des IA ne peut pas être utilisé commercialement car il ne peut pas être protégé par copyright, ce que méconnaissent beaucoup de gens qui pensent que cela va leur permettre d'illustrer sans frais leurs produits. En France, je ne sais pas légalement ce que cela implique, mais j'imagine que c'est similaire, même si la notion de copyright n'existe pas chez nous...

Macbesse a écrit : ↑dim. août 28, 2022 3:01 pm Pour l'avoir un peu testé, j'ai repéré tout de suite que c'était de l'image générée de manière procédurale. Les formes étirés, les mélanges d'objets, les artefacts un peu étranges... on est ici sur une image brute de décoffrage de Midjourney. Quand on n'y prend pas garde, elles se ressemblent toutes et c'est un peu lassant pour le regardeur.

Yusei a écrit : ↑dim. août 28, 2022 9:15 pm Pas vraiment, c'est de l'apprentissage automatique à partir d'une base de données, mais il n'y a pas un programmeur derrière qui décide d'émuler le style de tel ou tel artiste. Si aujourd'hui il y a encore des humains dans la boucle, c'est pour déterminer comment se fait cet apprentissage, mais ça nécessite de moins en moins d'avoir des connaissances sur le domaine concerné.

Du coup, un petit sujet pour parler outil de génération d'images. Je vais essayer d'être concis et de ne pas trop jargonner, tout en restant précis et factuel. N'hésitez pas à poser vos questions, j'y répondrai du mieux que je peux (l'IA pour l'image est une grande partie de mon travail).

(note aux modos : j'ai mis ce fil ici, je ne suis pas sûr que ce soit le meilleur endroit !)

De quoi parle-t-on ?

La génération automatique d'images ou synthèse d'image consiste à créer des… images, sans intervention humaine ou avec une intervention minimale. La plupart du temps, les images produites sont numériques.

C'est un domaine qui existe de façon formelle depuis les années 1980. Ses premiers usages étaient notamment la synthèse de textures, par exemple pour l'eau ou les nuages. Typiquement, un pionnier du domaine est Ken Perlin qui travaillait sur le film Tron en 1982.

Initialement, le procédé de génération est purement algorithmique : on créé une image en suivant une suite de règles permettant d'obtenir le style recherché.

Pourquoi on en parle maintenant ?

Parce que l'utilisation de l'apprentissage automatique (machine learning) a permis des avancées notables en synthèse d'image. Jusqu'au milieu des années 2000, les outils permettant de générer des images étaient très spécialisés et conceptuellement complexes. Par exemple, un synthétiseur allait se concentrer seulement sur la synthèse des visages, ce qui nécessitait de l'expertise de la part des équipes de développement pour concevoir un algorithme capable de simuler une peau réaliste, des yeux, une structure faciale plausible, une pilosité cohérente, etc.

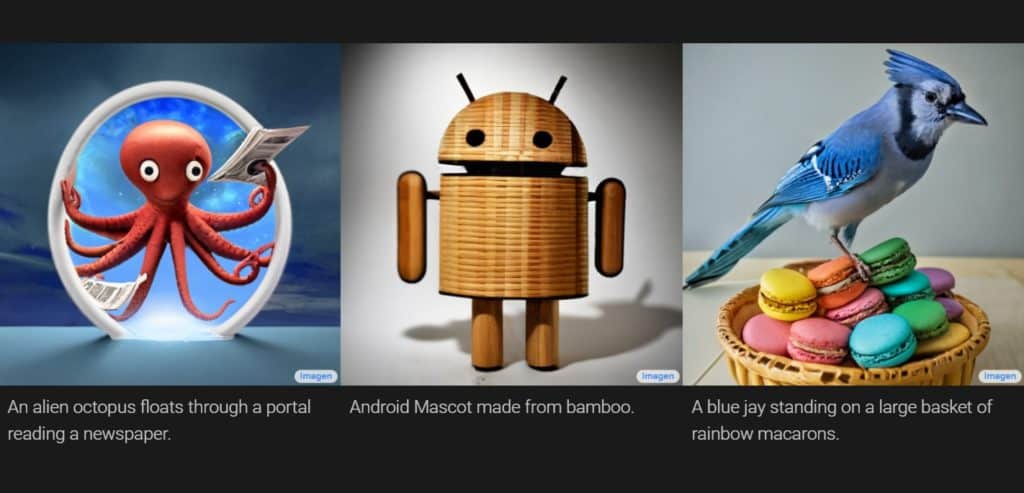

L'utilisation de réseaux de neurones profonds et de grandes bases de données d'images a permis de se passer de cette expertise, en permettant à la machine d'automatiquement trouver « comment » générer une image plausible pour l'œil humain. Les premiers succès grand public sont http://thispersondoesnotexist.com, puis Dall-E de OpenAI. Jusqu'à 2020, ces outils étaient encore de niche et utilisés soit dans le monde universitaire pour la recherche, soit par quelques grosses entreprises (typiquement, les GAFAM mais aussi Adobe, des studios de VFX et d'autres).

Comment fonctionne la génération d'images ?

On entre ici dans des détails un peu techniques. La génération d'image moderne se base sur des modèles génératifs, c'est-à-dire des modèles statistiques (généralement des réseaux de neurones artificiels) qui apprennent à reproduire des grandes quantité d'images. Le principe est toujours le même : on cherche les paramètres d'un modèle (~ les poids des synapses d'un réseau de neurones artificiels) qui permettent de minimiser une certaine fonction (la « fonction de coût ») que l'on peut calculer sur les exemples d'un jeu de données, par exemple provenant du web.

Il y a grosso modo trois approches :

- les auto-encodeurs : un double réseau de neurones : un Encodeur et un Décodeur. L'Encodeur transforme une image en texte (on suppose que l'on a une caption en plus de l'image du web). Le Décodeur reconstruit l'image à partir du texte. En production, on garde seulement le Décodeur.

- les réseaux de neurones adversaires (VQGAN+CLIP, Artflow) : on optimise alternativement deux réseaux de neurones : le Générateur et le Discriminateur. Le Générateur produit une image à partir d'un texte. Le Discriminateur apprend à distinguer les images fausses (du Générateur) des images réelles (qui viennent du web). Le Générateur apprend à tromper le Discriminateur. Plus le Discriminateur est bon, plus le Générateur doit produire des images qui ressemblent aux véritables images. Il suffit ensuite de donner un nouveau texte au Générateur pour produire l'image que l'on veut.

- les modèles de diffusion (DALL-E 2, Imagen, Midjourney, StableDiffusion) : compliqué à résumer. En bref, on dégrade volontairement une image du web en lui ajoutant du bruit aléatoire. Le Diffuseur apprend à inverser cette transformation. En production, on part d'une image constituée à 100% de bruit aléatoire et on applique plusieurs fois le Diffuseur, jusqu'à obtenir une image. Il faut utiliser des astuces pour pouvoir exploiter le texte.

Historiquement, l'approche 1 est connue depuis les années 70 mais n'a jamais vraiment rencontré le succès (pour des raisons mathématiques que je me garde d'évoquer ici). L'approche 2 était considérée comme la plus prometteuse depuis son introduction en 2014 mais a été récemment enfoncée par les succès de l'approche 3 en 2021/2022.

Est-ce que l'IA est créative ?

C'est la question qui revient le plus souvent. Elle fait débat parmi les spécialistes mais à mon avis la réponse est non pour trois raisons.

- Notre compréhension actuelle des réseaux de neurones pour la génération d'images est que l'on est en mesure de faire de l'interpolation sur la variété des images. Autrement dit, le modèle peut, dans des conditions favorables, créer de nouvelles images en mélanger des concepts mais pas d'en inventer de nouveaux. En corollaire, nos outils de synthèse excellent dans l'imitation.

- Le modèle reste un outil, au même titre qu'un appareil photo, et n'a aucune « intention ». La personne qui créé (qui imagine le prompt, c'est-à-dire le texte utilisé pour générer l'image) reste humaine.

- Il est préférable de ne pas anthropomorphiser les modèles obtenus par machine learning. In fine, il s'agit d'une fonction mathématique (certes compliquée) mais comparable en aucun point avec une personne.

La raison 1 permet d'ailleurs assez bien de comprendre que la principale limitation de ces outils de synthèse d'image n'est pas vraiment la partie technique, mais bien le corpus d'apprentissage. Un modèle ne créera jamais de visages de personnes noires s'il n'y en a aucune dans le jeu de données, ni un dessin de chat si vous n'utilisez que des photos DSLR 4k comme exemples. La curation de ce jeu de données est une problématique centrale pour les systèmes en production.

Est-ce que cela pose des problèmes éthiques ?

Il y a des tas de problèmes qui ont été largement discutés dans la presse : deep fakes, propagande, usurpation d'identité, etc. La façon dont ces problèmes sont traités à l'heure actuelle est assez mauvaise : les entreprises qui proposent ces services bloquent certains prompts ou analysent les images a posteriori pour rejeter celles qui ne respectent pas leur conditions d'utilisation.

C'est légal tout ça ?

Section à prendre avec un grain de sel puisque je ne suis ni avocat, ni juriste, ni magistrat.

Tout dépend de quoi on parle.

Pour générer des images de qualité quel que soit le prompt proposé, il faut avoir entraîné son modèle de synthèse d'images sur de très, très grands jeux de données (plusieurs centaines de millions d'images, voire plusieurs milliards). En général, il s'agit d'images (et de légendes) récupérées sur le web : DeviantArt, Reddit, Wikipédia, Flickr, etc. En théorie, seules les images sous licence permettant leur réutilisation le sont, néanmoins il est sûr et certain que de nombreuses images dans ces jeux de données ne respectent pas la licence (par exemple parce qu'elles sont été repostées par un tiers). Il y a aussi la question de savoir si les personnes photographiées auraient accepté de donner leur consentement à un tel usage de leur image.

Concernant les images générées en elles-mêmes, la législation est floue et varie grandement selon les pays. Les entreprises US semblent considérer que les images produites par leurs systèmes sont leur propriété. OpenAI accorde néanmoins une licence aux « artistes » (c'est-à-dire les personnes qui utilisent Dall-E 2) pour l'usage des images, y compris commercial. C'est également le cas de Midjourney. La question est épineuse pour un système open source comme Stable Diffusion, que n'importe qui (sous réserve d'avoir un bon PC) peut faire tourner sur sa machine. A priori, le consensus semble tout de même que les images générées sont au pire des œuvres dérivées suffisamment différentes pour être considérées comme nouvelles. Le droit d'auteur irait donc à la personne qui utilise le système.